- マーケティング

- Web広告

【話題のAIエージェント:ClaudeCodeの使用感】マーケティングにおけるAIエージェント作成の作り方と留意点

【非エンジニア向け】AIでデータ分析を自動化!ClaudeCodeとBigQueryで作る”賢い”レポート作成術

「毎週のレポート作成に時間がかかり、本来の分析や企画業務に集中できない…」 「データはあるのに、根拠のある改善提案まで繋げられていない…」

マーケティングや企画の現場で、こうした課題を抱えるチームは少なくありません。

本記事は、そんな悩みを持つ方向けに、AIアシスタント「ClaudeCode」とデータ分析基盤「BigQuery」を連携させ、データ分析を半自動化する「分析エージェント」を構築・運用した所感をまとめたものです。

例えば、以下のようなことを自動化できます。

例えば、「BigQueryの顧客データを分析して、セグメント別のマーケティング施策を提案し、実行可能なダッシュボードまで作成して」と依頼すると、Claude Codeは以下を統合的に実行します。

1)顧客データの探索的分析

2)コンバージョン顧客のクラスタリングによるセグメンテーションやコンバージョンユーザーの遷移の特徴

3)各セグメントの特徴抽出と施策提案

4)可視化ダッシュボードの構築

5)自動レポート生成機能の実装

さらに「来週のキャンペーン効果を測定する仕組みも追加して」と続ければ、A/Bテスト設計からKPI追跡まで一気通貫で構築します。このように、データ分析・戦略立案・実装・測定という一連のマーケティングプロセスを自律的に処理できる点が、従来のコード生成ツールとは大きく異なります。

これができるのも、Claude Codeが直接Claudeにコーディングタスクを委託できるエージェンティック(自律的)なツールだからです。単純なコード生成を超えて、複雑なマーケティング業務を統合的に自動化できます。

なお、BigQueryに関しては、こちらで詳しく説明しております。

https://docodoor.co.jp/staffblog/the_key_differences_between_google_analytics_and_bigquery/

専門用語も出てきますが、必ず平易な言葉で解説します。この記事のゴールは、根拠のある提案を「毎週・同じ品質」で安定してチームに届けられる仕組みを作ることです。

目次

【トピック1】仕事がどう変わる?具体的なAI分析エージェント活用シーン2選

活用シーン1:週次マーケティングレポート(KPIレビュー)

- 誰が・どんな場面で?: マーケティング担当者が、毎週のKPI進捗を会議で報告する場面。

- 得られるメリット:

- 期間を選ぶだけで、チャネル別の成果や前週比が自動で集計・可視化される。

- 「どのチャネルが良かった/悪かったのか」とその要因までAIが分析し、次のアクションのヒントを提示してくれる。

- 会議の準備時間が大幅に短縮され、議論に集中できる。

- よくある失敗と対策:

- 失敗: データが欠損していたり、更新が遅れていたりして、間違った結論を導いてしまう。

- 対策: 「品質ゲート」を設置。データが不完全な場合はレポート出力を自動で停止し、担当者に通知する。AIにはコンテキストウィンドウという覚えていられるテキストの限界があるので、このステップは必ず必要です。異常があるなら、必ずその時にチェックできる仕組みづくりをしましょう。大規模な解析をもとにしたレポートになると、細かいエラーは起こりがちなので必須です。

活用シーン2:デイリー広告運用監視(キャンペーン最適化)

- 誰が・どんな場面で?: 広告運用担当者が、日々のパフォーマンスをチェックし、予算を最適化したい場面。

- 得られるメリット:

- ROAS(広告費用対効果)の急落やCPC(クリック単価)の高騰といった”異常”をAIが自動で検知。

- 毎朝「対応が必要なキャンペーン」だけを確認する運用に変わり、無駄な広告費や機会損失を早期に防げる。

- よくある失敗と対策:

- 失敗: 祝日やセールなど一時的な要因で発生したノイズに過剰反応してしまう。

- 対策: 過去3日間の移動平均と比較するなど、短期的なブレに惑わされない分析ルールを設定する。なにと比較するかはドメイン知識、つまり扱っている、商品、業種や業界の知識も必要となるので、慎重に決めましょう。

【トピック2】分析エージェントを支える3つの重要ポイント

安定した分析エージェントを運用するには、いくつかの「前提条件」があります。特に重要な3つのポイントを紹介します。

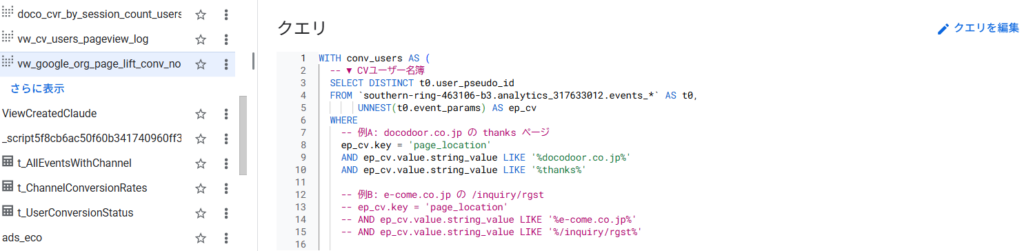

ポイント1:データ接続は「安全に小さく」始める

まずはCSVやスプレッドシートなど、手元にあるデータから試しましょう。API連携などは後からで十分です。

- 期間: 直近7日間

- 指標: 費用、クリック数、コンバージョン数、売上 上記のように対象を絞り、列名などのデータ形式を固定化することが、安定運用の第一歩です。以下の例では、参考にするクエリはViewとして保存して、列名にブレが出ないようにしています。

ポイント2:「品質ゲート」でAIの暴走を防ぐ

これが最も重要な仕組みです。AIが分析を始める前に、データの”健康診断”を自動で行います。

- 欠損チェック: 「コンバージョン数の列が95%以上空白」など、重要なデータが抜けていたら処理を停止。

- 更新停止チェック: 「データが24時間以上更新されていない」場合、古い情報で分析しないように警告。

- 異常値検知: 「ROASが前週比で30%以上悪化」など、通常では考えられない数値が出た場合、処理を中断し人による確認を促す。

この「止める勇気」が、間違った分析結果に基づく誤った意思決定を防ぎます。

ポイント3:出力は「再現性」を担保する

分析結果は、誰がいつ見ても納得できる形で出力することが信頼に繋がります。

- テンプレート化: レポートの構成(サマリー、グラフ、考察、アクション案)を統一する。

- 出典の明記: 「この数字は、いつ取得したどのデータに基づいているのか」という出典情報と時刻を必ず記載する。これにより、AIがもっともらしい嘘をつく「ハルシネーション」のリスクを低減します。

- 変化の可視化: 前週比などの数値を色分け(例:良化は緑、悪化は赤)し、変化を直感的に理解しやすくする。以下の例では、ClaudeCodeに指示し、ヒートマップ形式にしています。

【トピック3】【実践編】BigQueryで週次ROASレポートを自動化する流れ

ここからは、Googleのデータ分析基盤「BigQuery」を使い、GA4(Google Analytics 4)のデータと広告費データを結合して、週次ROASレポートを作成する具体的な手順を解説します。

STEP 1: データの設計と準備

まず、分析に使うデータの「形(スキーマ)」と「前提条件」を決めます。

- 使用データ:

- GA4の生データ: BigQueryに自動エクスポートされるユーザー行動ログ。

- 広告費データ: 各広告媒体から集計した日別のコストなどを格納したテーブル。

- 前提条件:

- チャネル名の統一: GA4の

utm_sourceと広告費データのchannelなど、媒体ごとの呼び名を揃えるルールを決めます。(例: ‘facebook’, ‘instagram’ → ‘meta’) - 期間の指定: 分析対象の期間を明確にし、重複カウントが発生しないようにデータを整理します。

- 通貨とタイムゾーンの統一: 通貨は円、タイムゾーンは日本時間(Asia/Tokyo)など、基準を揃えます。

- チャネル名の統一: GA4の

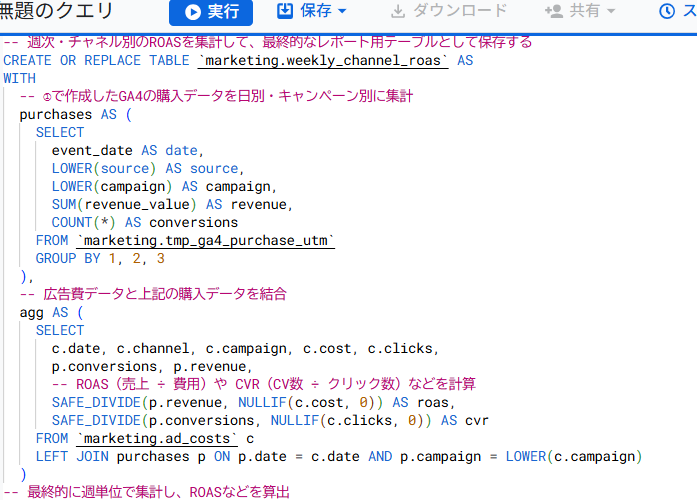

STEP 2: SQLでデータを抽出し、加工する

BigQuery上で、SQLという言語を使ってデータを取り出します。非エンジニアの方は「こんな指示を出しているのか」という雰囲気をつかんでください。

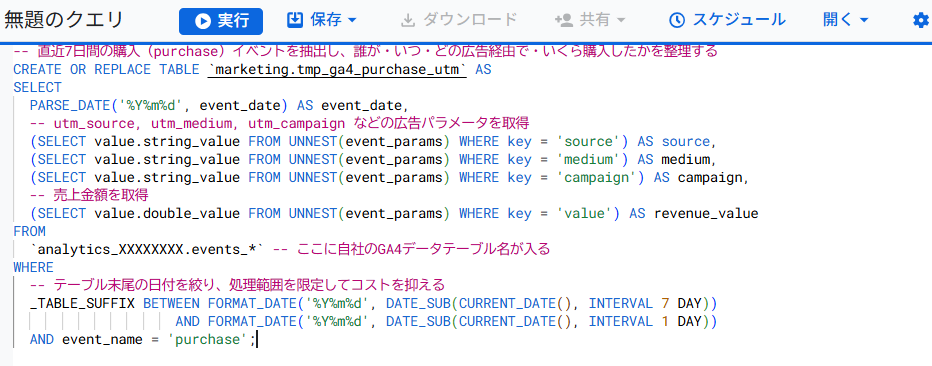

① GA4からコンバージョンと売上データを抽出するSQL

SQL

- やさしい解説: このSQLは、GA4の膨大なログの中から「直近7日間の購入データ」だけを抜き出し、広告キャンペーン情報(UTM)と売上を整理して、一時的なテーブルに保存する処理です。

_TABLE_SUFFIXで日付を絞るのがコスト削減のコツです。

② 広告費とGA4データを結合し、週次ROASを計算するSQL

- やさしい解説: 日別の広告費データと、先ほど整理したGA4の売上データを、日付とキャンペーン名をキーにして結合します。そして、チャネルごとの費用と売上を合計し、最終的なROASを週単位で算出しています。

SAFE_DIVIDEは「0での割り算によるエラー」を防ぐための安全装置です。

STEP 3: 品質ゲートで自動チェックするClaudeCodeづくり

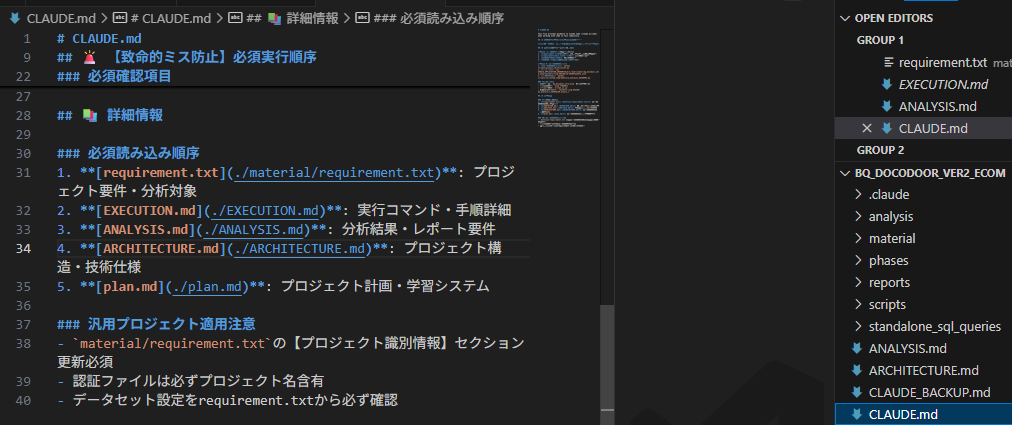

さてここからはClaudeCodeの設定です。Claude.mdというファイルの設定をし、プロジェクトの目的や処理の順序などの重要事項を決めます。ファイルごとの設定は割愛します。ただ、細かく分けて、そのファイル内容を確認するレビューが重要です。以下では、Claude.mdファイルで順番を指定しています。

まとめ・結論

AIによる分析自動化は、決して「AIに丸投げ」することではありません。**人の判断をより高度で正確にするための”補助輪”**です。

この記事を読んで「自分たちのチームでもできそう」と感じたら、ぜひ以下のステップで小さな成功体験を積んでみてください。

- 目的を1つに絞る: まずは「週次ROASの定点観測」など、最も課題に感じているレポートを1つだけ選びます。

- 7日分のデータで試す: いちばん簡単なCSVデータで、直近7日分だけの小さな分析エージェントを作ってみます。

- 品質ゲートを設定する: 「データが空っぽなら止める」「費用だけかかってコンバージョンがゼロなら警告する」といった簡単なルールからで構いません。

- 関係者でレビューする: 出力されたレポートをチームで見て、「これなら実務で使えるか」「何が足りないか」を話し合い、改善を繰り返します。

重要なのは、用語の定義を揃え、データの点検を怠らず、分析の記録を残すことです。この3点を守れば、チームのデータ活用レベルは着実に向上し、安定して成果を出せるようになります。

Webの世界は、AI技術の急速な進歩により日々進化を続けています。特に2025年以降は、自動化機能がさらに高度化する一方で、それを適切に活用するための専門知識の重要性も増しています。

自社での運用に限界を感じた場合は、最新のAI機能や高度な分析手法に精通したマーケティング専門家への相談をご検討ください。専門家の知見を活用することで、自社だけでは難しいレベルの成果向上と、競合他社との差別化を実現できるでしょう。

私たちは、Bigデータ解析と分析において豊富な経験を持ち、業界特性に合わせた最適な戦略提案が可能です。お気軽にご相談ください。成果向上に向けて、具体的で実践的なソリューションをご提案いたします。

▼ホームページ

マーケティングのお問い合わせはこちら。

https://docodoor.co.jp/lp_marketing/

Google、SNS広告運用のお問い合わせはこちら。

https://docodoor.co.jp/listing-ad/

▼お問い合わせ・ご相談はこちら

https://docodoor.co.jp/lp_marketing/#contact

用語集・定義

Claude Code(Anthropic のエージェント環境)で使う「知識の設計図ファイル」**です。一般的なマークダウンの形を取りつつ、AI エージェントがどう動くかをガイドする役割を持ちます。

Anthropic 社が開発した AI アシスタント(生成 AI の一種)。Claudeの最大の特徴は、「憲法AI」と呼ばれる開発手法です。これは、AIの応答が有害・差別的にならないよう、国連の世界人権宣言などの普遍的な原則を「憲法」としてAIに組み込み、自己監査させる仕組みです。これにより、人間のフィードバックへの依存を減らしつつ、倫理的で安全な応答を生成することを目指しています。

Google が提供する フルマネージド型のデータウェアハウス サービスです。大規模なデータを高速に分析できることを目的として設計されており、SQL を使ってデータをクエリできます。

データベースを操作するための標準言語です。

「データベースに何をしてほしいか」を命令するために使われます。

よくある質問(FAQ)

Q1. ClaudeCodeとBigQueryを使うメリットは何ですか?

A.従来は人がSQLを書き、毎週のレポートを手作業で作成していましたが、ClaudeCodeを組み合わせると自動化が可能になります。

-

定型作業を自動化 → 分析・企画の時間を確保できる

-

データの異常検知や要因分析までAIが補助 → 改善提案に直結

-

レポート品質が安定 → 毎週同じ粒度・形式で出力可能

Q2. データが欠損していた場合、AIは間違った分析をしてしまいませんか?

A.その通りです。そこで重要なのが「品質ゲート」です。

-

欠損チェック(重要指標が空なら停止)

-

更新停止チェック(古いデータなら警告)

-

異常値検知(通常あり得ない数値なら人に確認を促す)

こうした仕組みで「間違った結論を避ける」ことができます。

Q3. AIが出した分析は信用できますか?

A.AIの出力は万能ではなく「補助輪」です。信用性を高めるには以下の工夫が必要です。

-

出典(データ取得日時・対象テーブル)を明記

-

テンプレート化して再現性を担保

-

前週比や色分けで変化を直感的に示す

これにより、数字の正確性や判断の透明性が保たれます。

ドコドア マーケティング部

有資格:Google広告認定資格、Googleアナリティクス個人認定資格など